L’11 settembre 1973 viene rovesciato il governo di Salvador Allende. L’episodio segna storicamente l’ascesa del neoliberismo. Insieme al colpo di stato politico, però, ve ne è stato un altro che ha segnato la storia dell’informatica e che ha portato all’attuale sviluppo dell’Intelligenza Artificiale secondo una direzione determinata da un preciso apparato politico-economico-militare-culturale. Ne parliamo con il professore Andrea Cerroni, docente all’Università Bicocca di Milano, che, da sempre, approfondisce questi e altri temi e che ci ha spiegato la correlazione tra Salvador Allende e l’informatica.

Storicizzare, criticizzare, conoscere sono, oggi, le armi fondamentali per scalfire la retorica che avvolge sia il neoliberismo sia la tecnologia digitale e decostruire la loro capacità di imporsi “ontologicamente”, come necessità e dato di fatto incontrovertibile, inibendo la possibilità di immaginare altro: altre strade, altre soluzioni, altri digitali, altre società.

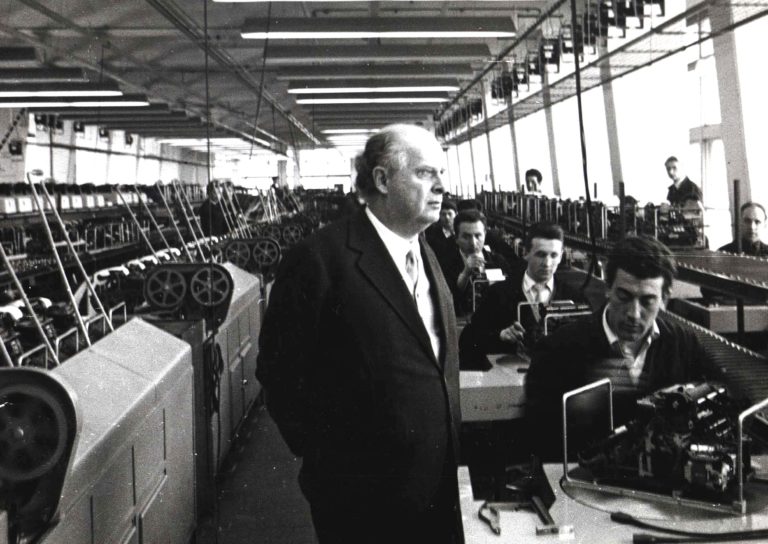

Abbiamo incontrato il professore Andrea Cerroni, docente all’Università Bicocca di Milano, che, da sempre, approfondisce questi e altri temi e ci ha spiegato la correlazione tra Salvador Allende e l’informatica. Che cosa lega IA e neoliberismo; per quale motivo è stato modificato il titolo di uno dei testi più importanti della cibernetica cancellando l’originale “uso umano degli esseri umani”; come è possibile ipotizzare una “tecnologia umanistica”, che da Dante arriva ad Adriano Olivetti (che ha inventato il primo PC della storia). Cerroni ci fa anche una raccomandazione: chiamiamola “Artificial Intelligence, perché nella traduzione italiana si perde il collegamento con i Servizi (segreti o meno)”.

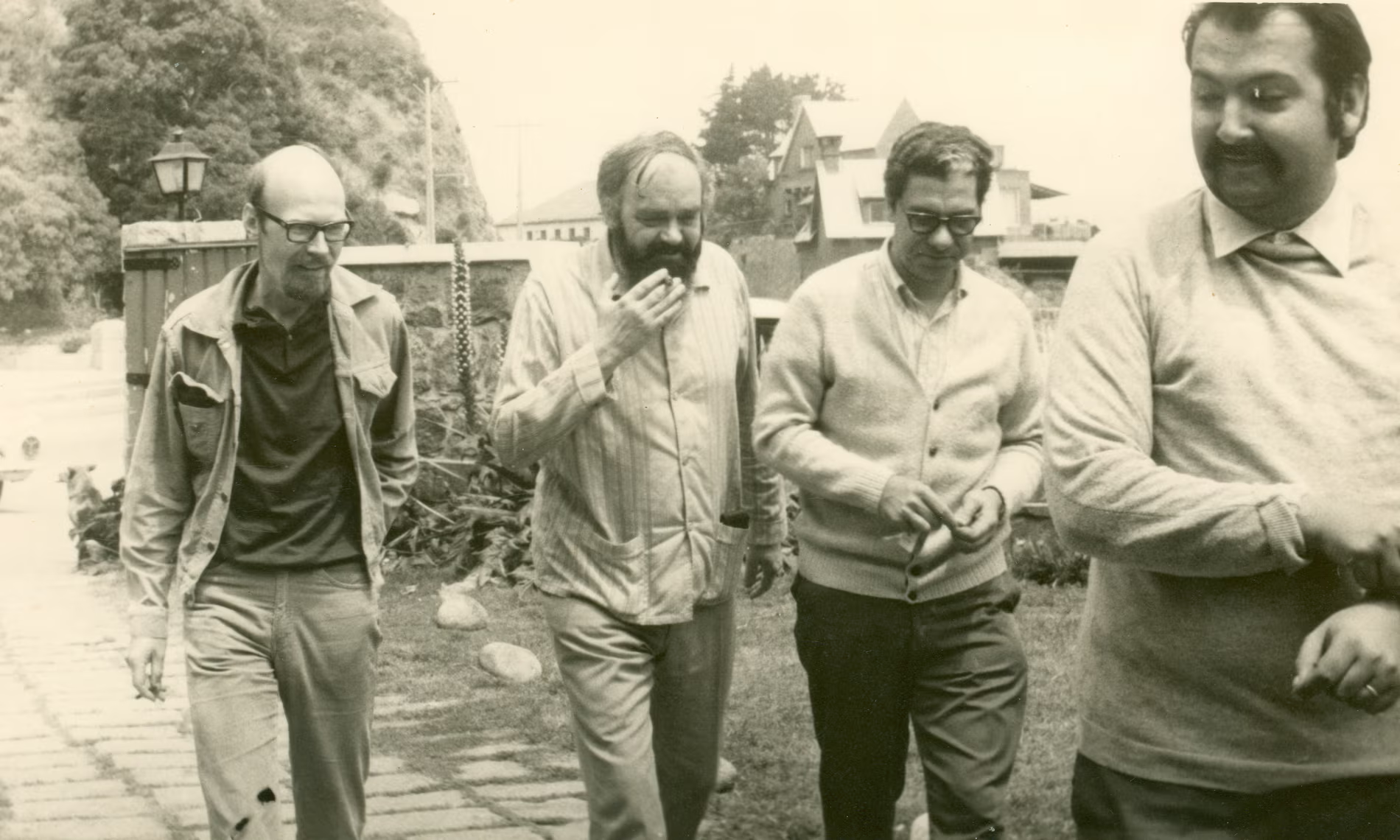

Professor Cerroni, Salvador Allende ha avviato lo sviluppo del primo, avveniristico, progetto cibernetico di governo dell’infrastruttura tecnologico-informatica, il Cybersyn. Come è nato, quale scopo aveva e come era organizzato tale sistema?

Allende aveva appena proceduto alla nazionalizzazione di molte aziende che però andavano adesso coordinate centralmente garantendo, al contempo, la effettiva partecipazione dei lavoratori e l’autonomia decisionale dei dirigenti locali, secondo l’impostazione politica di stampo socialista ma originale. Bisognava, insomma, superare sia la logica del mercato tipico del sistema capitalista nordamericano sia la burocratizzazione elefantiaca del socialismo sovietico. Solo un sistema cibernetico ispirato allo slogan wieneriano di “controllo e comunicazione” poteva garantire l’indispensabile, costante, trasparente flusso informativo fra centro e periferia.

In altre parole, Cybersyn era il braccio tecnologico dell’ideale politico di Allende e venne realizzato con i mezzi scarsi dell’epoca: un mainframe IBM 360 e 50 telescriventi. La complessità, infatti, può essere affrontata con mezzi semplici se impostati con l’opportuna intelligenza sistemica.

Professore, il colpo di Stato a Santiago del Cile dell’11 settembre 1973 ha rovesciato il governo democraticamente eletto di Salvador Allende segnando storicamente l’ascesa del neoliberismo. Perché dopo il golpe cileno il progetto Cybersyn viene abbandonato? Che cosa succede nella ricerca dell’informatica dopo l’ascesa del neoliberismo?

Perché la tecnologia non è neutra, contiene dentro di sé un’anima politica anche al di là dell’uso che se ne può fare. Pensi a mettere un oggetto davvero bello nella sua sala: a prescindere dall’uso che ne potrà fare, anche nessuno, anche il solo tenerlo lì, apparentemente inerte, cambierà qualcosa, se non nella sala, nel suo vivere quotidiano la sua casa, perché dentro di sé esso ha caratteristiche che interagiscono con noi prima che con quello che ne facciamo.

E quella del progetto cibernetico prevedeva la partecipazione dei cileni a tutti i livelli, dall’ultimo impianto di azienda nazionalizzata fino al governo centrale, con una trasparenza funzionale al governo democratico dell’economia per il bene collettivo e non ai mercati dei capitali internazionali.

In un recente seminario presso il Centro Nexa del Politecnico di Torino, Lei ha evidenziato che il 1973 segna una fase cruciale non solo per il passaggio dal socialismo al neoliberismo, ma anche per la storia delle tecnologie dell’informazione con la transizione dalla cibernetica di Norbert Wiener all’Intelligenza Artificiale di John von Neumann. Quali sono le differenze fra le due scuole?

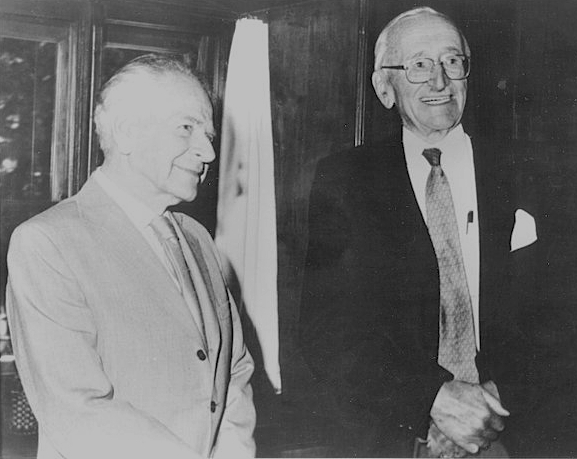

Potremmo riassumerle con una formula: mentre von Neumann (ed Herbert Simon dopo di lui con persino maggior risultato culturale) intendeva “razionalizzare l’essere umano”, Wiener intendeva “umanizzare la macchina”. Quelle caratteristiche della mente umana riscontrate dalla psicologia erano, infatti, concepite dal primo come limiti intrinseci della mente umana che dovevano essere aggirati grazie alle tecnologie, mentre, lungo la linea interpretativa inaugurata dal secondo, esse erano concepite come caratteristiche specifiche da rispettare, assecondare, assistere mettendo le tecnologie a loro servizio.

Quindi, l’ideale di von Neumann comprendeva la possibile sostituzione della mente umana con strumenti tecnologici per un’a ‘ottimizzazione dei risultati in giochi (di fatto, sempre a torta fissa, a somma-zero, cioè del tipo io-vinco-e-tu-perdi). Per Wiener, invece, bisognava pensare a un “controllo” dello sviluppo di tali strumenti per salvaguardarli dall’azione della tecnocrazia e del complesso militare-industriale, pericolo già all’epoca tanto realistico da essere evocato persino da Dwight Eisenhower nel suo discorso di addio alla nazione.

Il 1973 è anche l’anno di fondazione della Trilaterale, che tanto operò a livello globale per l’affermazione del neoliberismo e solo tre anni dopo fu compiuto l’analogo golpe argentino, seguito a breve dall’ascesa di Thatcher in UK e Reagan in USA.

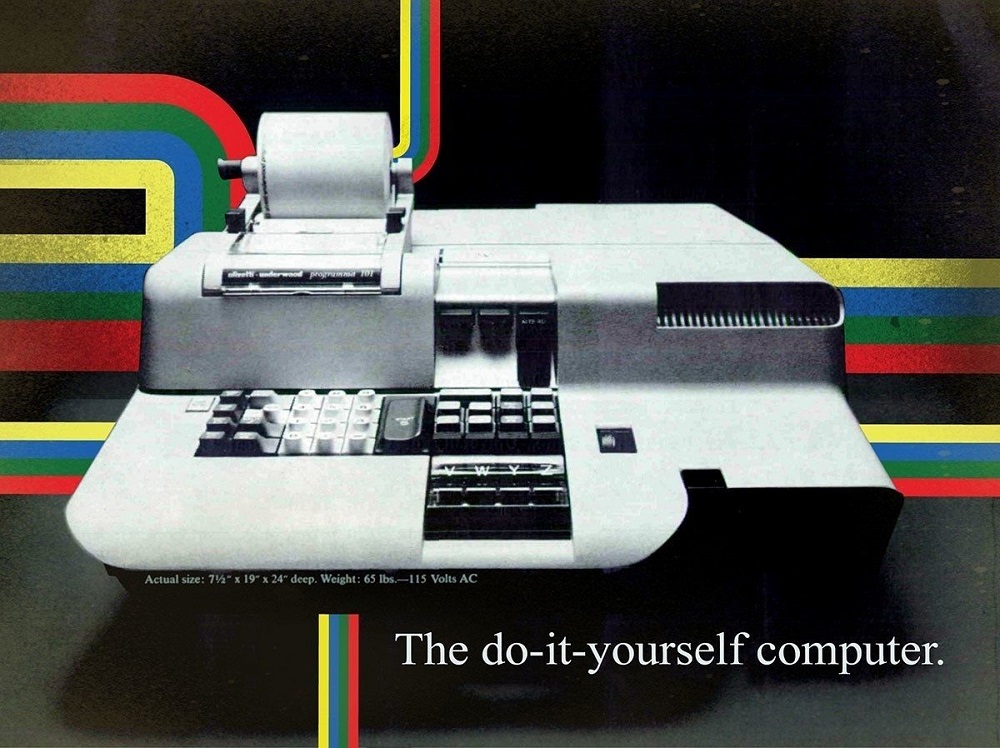

Quelli furono anche gli anni dell’eclissi della cibernetica e dell’avvento dell’informatica statunitense e non si pensi che fosse uno sviluppo inevitabile. Che ne sarebbe stato del mondo dei computer se non fossero morti improvvisamente nel giro di un anno e mezzo (1960-1961) sia Adriano Olivetti, la cui impostazione politico-sociale è ben nota, sia il capo dell’informatica, Mario Tchou, formatosi alla scuola di Enrico Fermi, con la conseguente svendita della divisione elettronica a General Electric?

Ah, ricordiamoci che il primo personal computer, la P101 che fu usata anche per i calcoli necessari all’atterraggio sulla Luna, fu comunque lanciato dall’Olivetti nel 1965, ma la corsa all’informatica era ormai persa. Ma si pensi che le problematiche di cui oggi ci occupiamo a proposito della AI, forse con eccessiva enfasi propagandistica, sono in gran parte quelle che i cibernetici volevano affrontare sin dall’origine delle scienze dell’informazione.

Professor Cerroni, quali sono state le tappe storiche fondamentali che hanno saldato il sodalizio fra IA e neoliberismo?

Mi consenta una precisazione. È bene chiamarla Artificial Intelligence perché nella traduzione italiana si perde il collegamento con i Servizi (segreti o meno) volti a mantenere l’ordine sociale esistente, perché di qui è immediato notarne la valenza politica. Tale denominazione fu coniata nel 1956 da J.McCarthy, ma già dalla Seconda Guerra Mondiale si era palesata una frattura con la cibernetica.

Basti pensare all’entusiasmo di von Neumann per lo sviluppo dell’atomica, e persino per il suo successivo uso preventivo contro l’URSS, d’accordo con il suo sodale E.Teller, e alla totale estraneità di Wiener al progetto Manhattan. Il flusso di finanziamenti sia federali sia privati nel corso della guerra fredda fu, anche comprensibilmente, deviato verso l’AI.

L’informatizzazione conseguente avvenne parallelamente alla neoliberalizzazione dell’Occidente, ovvero parallelamente al ritiro progressivo delle conquiste del welfare che proprio qui era nato, per riprendere il controllo di un ordine che appariva minacciato dall’espandersi di una democrazia che manifestava limiti pericolosi agli occhi dell’élite del potere. Solo nel corso degli ultimi decenni ha ripreso lentamente quota la tradizione wieneriana, con quella che viene definita la seconda cibernetica, parallelamente, guarda di nuovo il caso, al crescere della critica al neoliberismo.

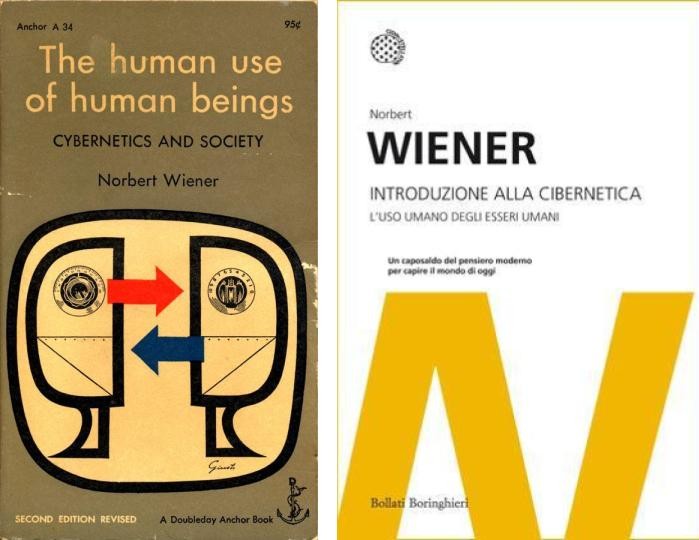

Possiamo dire che la presunta neutralità dell’IA ben si presta all’ottimizzazione delle rendite di posizione sui mercati, a differenza della cibernetica che invece si pone sin dall’inizio la questione di un uso umano degli esseri umani, come recita il titolo del famoso volume di Wiener ben al di là di ogni ipocrisia che ha imposto quasi in tutto il mondo titoli assai più ‘accettabili’ (del tipo Introduzione alla cibernetica).

Lei ha ricordato un passaggio in cui Wiener sottolineava nel 1948 che “la macchina automatica (…) è l’esatto equivalente economico del lavoro schiavo. Qualsiasi lavoro che compete con il lavoro degli schiavi deve accettare le condizioni del lavoro degli schiavi”. Ci stiamo avviando ad un mondo di schiavi?

Questo è esattamente il destino di una barbarie che ci vede come mero capitale umano, portfolio di competenze ovvero di lavoro potenziale da vendere al mercato: il nostro lavoro trattato come merce al pari di terra e moneta, che merci peraltro non sono neppure loro. L’uomo al servizio dell’economia e non l’economia al servizio dell’uomo, per dirla con il nostro Adriano Olivetti. Torna, insomma, di attualità il motto di Rosa Luxemburg socialismo o barbarie, per ricercare una vera e non fittizia (blairiana) terza via.

Come si vedeva con chiarezza anche oltre cortina, nella Primavera di Praga di Dubcek e Richta, di poco precedente a Santiago ‘73, la tecnologia può essere impostata anche proprio allo scopo di sviluppare un nuovo umanesimo, quello che chiamo un umanesimo tecnologico. Ma alla tradizione dell’Umanesimo italiano dobbiamo oggi aggiungere il ruolo dello Stato democratico di diritto, fondamentale per una reale democrazia. Non a caso proprio lo Stato è sempre stato l’obiettivo di tutti i neoliberisti, che lo hanno voluto sufficientemente debole per tutto, tranne che per l’imposizione della loro dottrina.

Professor Cerroni, il senso comune sembra essersi radicalizzato sulla credenza secondo cui l’unica differenza fra umano e IA risiederebbe nei sentimenti (di cui l’IA non potrà mai fare esperienza) mentre la nostra mente è concepita come razionalità astratta, grezzo “dispositivo computazionale limitato, da correggere attraverso la razionalità delle macchine”. Come è riuscito a imporsi tale approccio riduzionista? Quale è stato il ruolo cruciale di alcune delle personalità più influenti del ‘900 come Karl Popper in quella che Lei definisce “naturalizzazione e sacralizzazione” del riduzionismo?

Nella modernità sono state presenti due correnti divaricatesi all’epoca della Riforma protestante: l’una, che ha conquistato l’egemonia in Occidente e che potremmo chiamare cartesiano-calvinista, e l’altra che non ha trovato ancora un nome, ma non è mai del tutto scomparsa. La prima corrente ha preso sin troppo sul serio il dualismo che lo stesso Descartes aveva peraltro già messo in discussione nelle Meditazioni metafisiche, assegnando così alla mente un posto del tutto avulso dalla corporeità e che anzi trova negli influssi di quest’ultima tutti e soli i suoi limiti.

Ma siccome non esiste mente umana senza corporeità, la mente viene automaticamente ridotta a pura logica: sorge perciò il compito di una expurgatio di tutto ciò che non è pura mathesis universalis (Leibnitz), ma corruzione che la rende soggetta a passioni e idiosincrasie che ne inficiano il valore di scientificità, rendendola pura opinione personale, per ciò stesso falsa. Come se la scienza fosse in-umana, per non dire dis-umana, come nella contrapposizione fa science e humanities.

La seconda corrente è invece quella che guida Dante nella Commedia e porta alla ricerca del connubio, già di Cicerone, fra conoscenza universale e impegno personale, fra idealità e corporeità, e se vogliamo macrocosmo e microcosmo, attraverso un concetto stilnovista (umanistico-rinascimentale e ben presente in una tradizione cristiano-cattolica) di amore. Se nella dea greca Afrodite questo era proprio la fonte della creatività, Dante scriverà che nella mente mi ragiona e arriverà successivamente all’economia civile dell’illuminismo napoletano, per esempio. Lungo la prima linea ciò che ci rende umani è un peccaminoso limite da rimuovere, lungo la seconda esso è proprio l’apice della nostra creatività distintiva.

Popper, non per niente tra i fondatori della Mont Pelerin Society assieme ad Hayek, ha svolto il ruolo di sistematore dell’epistemologia neoliberale per dare fondamento al cosiddetto individualismo metodologico per le scienze dell’uomo. Basti pensare alla frattura da lui disegnata fra Mondo-2, quello della psiche idiosincratica del singolo individuo, e Mondo-3, quello della conoscenza oggettiva, ovvero senza soggetto conoscente.

Ma già da qui si vede una contraddizione palese: da un lato, l’ipervalutazione idealistica dell’individuo, tipica del liberalismo, che pone l’essere umano al di fuori di ogni socialità e storicità nella forma prevista dalla sua visione del mondo; dall’altro la svalutazione di ogni tratto che rende un individuo l’essere umano concretamente esistente, in quanto lontano dal suo modello idealistico, date le inevitabili declinazioni storico-culturali. E per giunta si consegnano di fatto le chiavi della conoscenza a qualcuno che magicamente si sottragga alle determinanti storico-sociali.

Non a caso i bersagli privilegiati dei suoi acrimoniosi attacchi divennero sia Karl Marx che Sigmund Freud. Il primo, proprio dal doppio scambio hegeliano tra astratto e concreto, era partito per lo smascheramento dell’ideologia liberale e la formulazione di una proposta politica di radicale cambiamento sociale attraverso lo studio dell’uomo quale oggetto di scienza delle dinamiche sociali, nelle quali è sempre inserito costitutivamente. Il secondo, invece, era partito dalla considerazione del soggetto umano come ente studiabile quale oggetto di scienza nelle sue dinamiche psicologiche. Il culto di un uomo astratto, inteso come natura umana astorica e intangibile, andava dunque considerato frutto di una ideologia e la manifestazione di un disagio tipici della civiltà moderna.

Hanno voglia a ripetere con Thatcher che la società non esiste: questo non è altro che il dettato normativo, politicamente coercitivo dall’alto di chi si è impossessato della società, rivolto alla distruzione sistematica della società welfaristica per la restaurazione di una società elitaria retta dal liberalismo proprietario ottocentesco.

Professor Cerroni, tra “apocalittici e integrati”, passatisti e futuristi, pessimisti e ottimisti, il dibattito sull’Intelligenza Artificiale è sviscerato dalla sfera pubblica in modo talmente “grezzo” e approssimativo che a farla davvero da padrone alla fine sono tifoserie lontane da ogni complessità e critico discernimento del tema. Non è questo un modo per tenere la gente lontana da ogni possibile sfera decisionale? Chi è responsabile di ciò?

Siamo in un’epoca in cui è sempre più difficile discutere su numerosi argomenti, quelli che chiamo argomenti divisivi, senza finire in una battaglia tra fazioni trincerate che ammette solo un esito: rinchiudersi nella propria bolla. È in effetti un modo assai efficace con cui chi detiene posizioni di privilegio nella sfera pubblica facilmente mette a tacere ogni possibile dissenso e fa, peraltro, showbusiness. Si pensi al proliferare di etichette che ostracizzano le opinioni che non trovano spazio nei principali media gestiti caparbiamente da un monopolio culturale che opera come in concerto.

E certo che la tecnologia, in quanto strumento di costruzione del mondo, fa un uso degli esseri umani che solo cittadini in dibattito, fra esperti e non esperti, con modalità differenti ma non aggirabili, come già indicato da Tucidide 2500 anni fa, sono i meglio attrezzati per giudicare un uso umano in un sistema sociale che si voglia continuare a definire democratico anche nel XXI secolo.

Paul Virilio, uno dei filosofi più pessimisti circa lo sviluppo dell’informatica, ha dichiarato in un’intervista di “non essere contrario alla tecnica, ma alla retorica della tecnica”. Noi oggi siamo storditi da una grande narrativa futurista dominata dalla retorica della tecnologia, di questa tecnologia in capo ad un preciso apparato politico-economico-militare e a un manipolo di aziende della Sylicon Valley. È possibile immaginare altri digitali, altre Intelligenze Artificiali per un “uso umano degli esseri umani” al servizio della democrazia? Cosa può insegnare l’esperimento cileno del Cybersyn?

L’insegnamento principale che ne possiamo trarre, a mio avviso, è presto detto: la tecnologia ha uno statuto etico e politico anzi antropologico, già a monte del suo uso. Potremmo dunque dire che non è di per sé né buona né cattiva, ma di sicuro non è neutra. Se io qui, all’inizio di questa intervista, avessi posato una pistola sul tavolo fra noi, sono sicuro che avrei cambiato qualcosa in questa intervista, forse qualcosa che è proprio quello cui entrambi più teniamo: la qualità della nostra comunicazione come relazione umana.

La tecnologia possiede già una teoria dell’uomo e la sua de-politicizzazione è l’arma per una ‘naturalizzazione’ delle diseguaglianze che caratterizzano la società neoliberale, ovvero per spostare la questione dal piano di progetto politico a quello di un adattamento etico, (sostenibilità, resilienza).

Lei ha organizzato a gennaio del 2024 presso l’Università Bicocca di Milano il convegno internazionale “Dentro la società neoliberale. Declinazioni filosofiche e sociologiche del contemporaneo“. Che cosa è in realtà il Neoliberismo?

È una dottrina sociale nata per disarticolare il tessuto di relazioni che tengono insieme i membri di una società nell’illusione che senza di essa l’individuo possa manifestare la sua natura essenziale, con i suoi ‘talenti’ e le sue ‘eccellenze’ naturalmente e insondabilmente ascrittive, riconducendo la vita sociale a nient’altro che (e questa è la formula magica di ogni riduzionismo) la somma delle manifestazioni delle libera volontà di tali individui idealizzati.

Esso si presenta notoriamente in tre varianti: scuola austriaca, ordoliberismo germanico e monetarismo statunitense. Ciascuna delle tre non è altro che la declinazione del medesimo core ideale in società che provenivano da un passato diverso pur dentro alla modernità occidentale. Tanto è vero che quando l’urgenza del presente ha richiesto di trovare un accordo per delineare una prospettiva futura non è mai stato un compito troppo difficile, dal Colloque Walter Lippmann (1938), alla Mont Pelerin Society (1947) fino al Washington Consensus (anni ’80).

In particolare, esso si presenta con una teoria scientifica in campo economico che considera questo come arena di libero confronto fra pulsioni e scelte individuali e che, però, considera se stessa come un metodo generale per trattare tutte le questioni degli esseri umani al fine dichiarato di cambiarne il cuore e l’anima (Thatcher). Se ogni scambio è un voto, è sufficiente confrontare di quante possibilità di scelta, ovvero ‘voti’, lei ed io disponiamo con quante ne dispone chi detiene ricchezze più grandi di quelle di grandi stati.

Wiener ha scritto che “sia che affidiamo le nostre decisioni alle macchine di metallo sia che le affidiamo alle macchine di carne e sangue che sono uffici e vasti laboratori, eserciti e corporazioni, non riceveremo mai le risposte giuste se non poniamo le domande giuste”. Quali sono le domande giuste che dobbiamo porci?

A mia conoscenza, vi è solo una ‘domanda giusta’ a questo livello di generalità: cosa pensiamo dell’umanità? Al fondo di ogni politica vi è una antropologia. L’antropologia neoliberale è racchiusa nella formula negativa di homo homini lupus, tratta con qualche forzatura da Plauto e fatta propria dal fondatore del pensiero politico moderno, Hobbes. Da qui per una libertà concepita dai proprietari (di terre, di capitali e di uomini) la presenza di altri non poteva che essere un limite piuttosto che una realizzazione.

Personalmente preferisco, dunque, la formula che già Cecilio Stazio obiettò a Plauto: homo homini deus est si suum officium sciat (l’uomo è un dio per l’uomo, se conosce il proprio dovere). L’altro è ‘dio in terra’ per ciascuno di noi, un creatore assieme a noi di qualcosa che è più della somma delle proprietà di cui individualmente disponiamo, se solo entrambi prendiamo consapevolezza e responsabile impegno per il bene comune.

E così facendo costruiamo l’heritage, la humanitas, perché è nella nostra natura “cambiarci nello scambio”: la vita umana è (s)cambio. E qui c’è un’intera tradizione politica che, almeno dal circolo degli Scipioni in Roma antica, passando, appunto, per Dante e l’economia civile settecentesca, arriva al capitalismo olivettiano e al pensiero politico di Antonio Gramsci e, dunque, alle tradizioni proprie del cattolicesimo sociale e del solidarismo socialista sui quali, non per niente, è fondata la nostra Costituzione.

Andrea Cerroni è sociologo della conoscenza e Professore Ordinario di Processi sociali e comunicativi presso l’Università di Milano-Bicocca. Laureato in Fisica con esperienze di Controller in imprese high-tech, è stato il Delegato Nazionale Rappresentante per l’Italia nel Programme committee – Science in society per il 7° Programma Quadro europeo.

Fra le sue pubblicazioni ricordiamo: “Tecnica e libertà fra Praga e Santiago. A mezzo secolo da un doppio bivio politico-tecnologico”, Quaderni di sociologia (2024); “L’Università finisce. Taylorismo della mente fra marketing e burocrazia”, Riflessioni sistemiche (2023); “Techne, logos e utopie: Ripensare la fabbrica del mondo per un umanesimo tecnologico”, Cambio (2022); “Contemporary Sociological Theology. The Imagination that Rules the World”, Edward Elgar (2022); “Comunicazione e incertezza scientifica nella società della conoscenza. Teoria e casi studio di sociologia del rischio”, Franco Angeli (2021).

Salve, interessantissima intervista.

I valori e gli auspici espressi sono però fattualmente contraddetti dalle tecnologie utilizzate dal sito stesso: i font di Google, Google Tag Manager, Gravatar e i servizi WordPress permettono ad aziende statunitensi, impegnate nel capitalismo di sorveglianza e manipolazione, di profilare accuratamente tutti i lettori, in modo da poterli utilizzare come burattini, orientandone opinioni e comportamenti.

Si tratta di un problema grave e sistemico, diffuso su molti siti, ma fingere che non esista rende complici degli interessi che si cerca (almeno nei contenuti) di combattere.

Vi invito dunque a ripulire il vostro sito, spostando il tutto su server europei e rimuovendo qualsiasi comunicazione verso GAFAM & friends.

Un elenco dettagliato dei maggiori problemi del sito giubberossenews.it lo trovate su https://webbkoll.5july.net/it/results?url=http%3A%2F%2Fgiubberossenews.it%2F

Ho provato a cercare in “Chi Siamo” un’email a cui segnalare questi problemi, senza trovarne alcuna.

Rimango disponibile per ulteriori chiarimenti tecnici.

Il professore osa contraddire il byas più ripetuto; bene! Aggiungo che nessun prodotto tecnologico è neutro, mai : comporta sempre una ontologia propria – dalla produzione, alle correlate conseguenze, fino alla dismissione – alla quale occorre adeguarsi, a prescindere dall’eventuale uso.

Perciò, non sono mai neutre ne le scienze ne, tanto meno, le tecnologie….